Představte si, že máte firemní web, chystáte se dělat nový, takže si chcete ten stávající schovat, abyste po jeho vypnutí měli něco, kam se můžete podívat co tam kde bylo. Nebo potřebujete někde, kde není Internet, ukazovat něco co na webu, Internetu, prostě visí. Potřebujete si udělat kopii webu, offline a ideálně ještě takovou, aby se dala (alespoň z větší části) používat. Tedy proměnit ty různé skripty a automaticky generované věci na statické HTML stránky.

Můžete ale třeba potřebovat stáhnout jenom část webu, třeba všechny obrázky v určité galerii, nebo všechny soubory, které jste na web nahráli za pár posledních let. Nebude vám vadit, že uplně všechno nebude funkčí (třeba vyhledávání určitě nebude, nebo nějaké ty formuláře závislé na dalším zpracování).

HTTrack Webstie copier

Jedna z mnou oblíbených možností je HTTrack Websiti copier – https://www.httrack.com/, Bez problémů funguje ve Windows i Linuxu, umí dokonce i Android. Můžete ho používat z příkazové řádky i z grafického rozhraní. A je poměrně dobře nastavitelný. A v zásadě ho stačí pustit a nechat běžet poté, co mu řeknete co má stáhnout (občas se tomu říká mirror nebo vytvořit zrcadlo). Po stažení je dobré si ověřit jak to dopadlo, může se stát že se to nepovede. A protože tady každé stahování máte založené jako „projekt“, tak můžete stahování i kdykoliv později opakovat.

POZNÁMKA: Prosím pozor, tohle o čem tady píšeme vytvoří něco jiného, než záloha vašeho webu – tedy kompletní stažení všech souborů, skriptů, databází a dalších potřebných věcí z vašeho hostingu. K tomu slouží zcela jiné pomůcky.

WGET

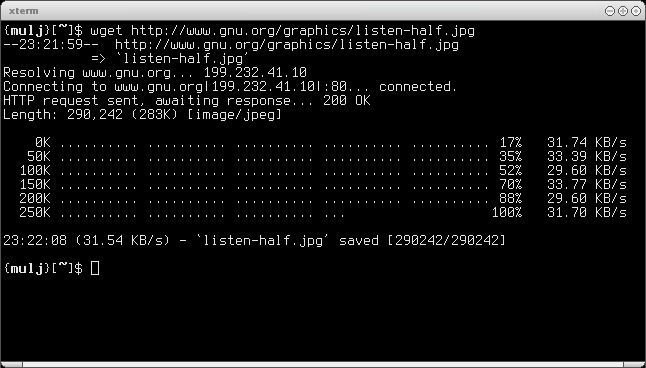

Další velmi užitečnou pomůckou je wget – jde v zásadě hlavně o nástroj z Unixu, ale snadno ho najdete i pro Windows. Funguje z příkazové řádky, osobně ho velmi často používám i jen pro prosté stažení jednoho souboru z Internetu, nebo stažení webové stránky, na kterou nechci vstoupit prohlížečem. Umí ale udělat offline kopii celého webu – třeba tka, že ho použijete jako:

wget --mirror --convert-links --adjust-extension --page-requisites --no-parent http://adresa_webu

Wget má samozřejmě parametrů ještě více, ale to už je na vás, abyste se to případně naučili. Není ale tak vhodný jako předchozí HTTrack, na některých webech se kopie prostě nepovede.

POZNÁMKA: Pokoušet se stáhnout cizí web není úplně dobrý nápad, neměli bystě něco takového dělat, pokud ten web není váš, případně se chovat ohleduplně, protože tažení celého webu můžete zatížit velmi výrazně webový server.

Další možností?

Osobně dávám přednost prvnímu jmenovanému, druhé, jak už bylo napsáno, slouží pro stažení jednoho souboru nebo jedné stránky. Možnosti je ale více. Třeba:

- Pavuk (Linux, pozor odkaz vede na SourceForge, od roku 2015 nedůvěryhodné)

- PageNest offline browser (Windows)

- Webripper (Windows), nově nahrazený NCollector Studio

- WinWSD (Windows) ale tady si myslím, že už před mnoha lety umřel

- Website Ripper Copier (Windows)

- ScrapBook je rozšíření pro Firefox schopné stahovat i celé weby

- WebZIP (Windows)

- BackStreet Browser (Windows)

- SiteSucker je dostupný pro MacOS a pro iOS (což může být poměrně zajímavý vychytávka)

Klasicky by se dalo ještě nejspíš pokračovat dalšími, byť to ani v zásadě není potřeba (jsem si dost jist, že HTTrack a WGET vám splní vše co budete potřebovat). Ale pokud třeba máte nějaký svůj oblíbený „mirrorovací“ software pro weby, tak dejte vědět. Doplníme.

Online možnosti

Existují různorodé služby, které umožňují uložit nějaký web či konkrétní jednu webovou stránku. Typickým příkladem je Internet Archive a tamní Wayback Machine (viz Znáte Internet Archive: Wayback Machine? A víte, co je to Google Cache?), ale tam sice můžete požádat o archivaci určité stránky v daný moment, ale není to vyloženě určeno k vlastnímu využití.

archive.is je užitečná alternativa, které řeknete jakou adresu chcete uložit a služba si ji uloží a bude dostupná kdykoliv později. Můžete tam i vyhledávat v již uložených stránkách (uložených kýmkoliv). Podle všeho to navíc ukládá jak obsah, tak něco jako screenshot – uloženou stránku si můžete stáhnout i jako ZIP archiv.

![2015-10-11 16_53_43-WinHTTrack Website Copier - [Testovací.whtt]](https://365tipu.cz/wp-content/uploads/2015/10/2015-10-11-16_53_43-winhttrack-website-copier-testovacc3ad-whtt.png?w=660)